[Archiwum] Moje szkolenie dla osób zainteresowanych OSINT i narzędzi AI przy tłumaczeniu filmów i tekstów

(Nawet dla osób, które nie znają języka docelowego… a dla profesjonalistów trochę o tym, jak zaoszczędzić sobie trochę czasu.)

Poniżej opis archiwalnego szkolenia oraz samo szkolenie (sierpień 2024) dotyczącego OSINT.

link zapasowy na X (dawniej Twitter) https://x.com/i/broadcasts/1vOGwrwjmWrKB

- Generowanie napisów do filmów AI: Użycie darmowego narzędzia Subtitle Edit i modelu Whisper (lokalnie, bez wysyłania danych na zewnątrz) do automatycznego tworzenia transkrypcji z audio. Porównanie różnych silników Whisper (np.

`Const-me/Whisper`). - Tłumaczenie i korekta napisów: Wykorzystanie DeepL API do szybkiego tłumaczenia wygenerowanych napisów bezpośrednio w Subtitle Edit, a następnie użycie Gemini do poprawy jakości tłumaczenia (podając mu zarówno oryginał, jak i wstępne tłumaczenie). Podkreślenie znaczenia znajomości języka źródłowego przy weryfikacji.

- Finalizacja napisów: Użycie funkcji Subtitle Edit do sprawdzania pisowni, naprawiania typowych błędów (np. zbyt długie linie, czas wyświetlania) i eksportowania napisów bez potrzeby ponownego kodowania całego filmu.

- Praca ze zrzutami ekranu i tekstem na obrazach:

- ShareX: Darmowe narzędzie do robienia zrzutów ekranu, z możliwością prostej edycji (pikselowanie, dodawanie tekstu) i szybkiego tłumaczenia fragmentów za pomocą DeepL.

- Microsoft PowerToys (Text Extractor): Wyciąganie tekstu (OCR) bezpośrednio z obrazów lub fragmentów ekranu.

- Poprawa jakości obrazów (Upscaling): Użycie narzędzia Upscayl do zwiększania rozdzielczości i poprawy szczegółowości obrazów o niskiej jakości, np. klatek z filmów czy zdjęć. Porównanie różnych algorytmów.

- Prosta edycja grafiki: Krótkie wspomnienie o Paint.NET jako narzędziu do pracy na warstwach, przydatnym przy tworzeniu bardziej złożonych grafik (np. map z oznaczeniami).

- OSINT (Biały Wywiad) - Narzędzia i techniki:

- Telegram: Efektywne przeszukiwanie dużej liczby kanałów pod kątem słów kluczowych do śledzenia tematów i zbierania informacji. Analiza treści, w tym propagandy.

- Geolokalizacja: Użycie Google Earth Pro i Street View do identyfikacji miejsc z nagrań/zdjęć oraz analizy terenu (w tym historyczne zdjęcia satelitarne).

- Wikimapia: Wykorzystanie jako źródła informacji o zidentyfikowanych obiektach, w tym potencjalnych obiektach wojskowych.

- Ogólna filozofia: Nacisk na wykorzystanie darmowych, często open-source’owych narzędzi jako alternatywy dla płatnych usług o porównywalnej lub niższej jakości. Pokazanie praktycznego przepływu pracy umożliwiającego szybkie przetwarzanie i publikowanie informacji.

Co się zmieniło od czasu nagrania?

Nagranie pochodzi z sierpnia 2024 r. i bardzo wiele od tego czasu się zmieniło :) Na przykład od tego czasu API Gemini 2.5 PRO przebiło jakością model o1 od OpenAI, a dodatkowo przestałem już ręcznie przepisywać prompty. Zamiast tego stworzyłem kilka skryptów automatyzuyjących, które przekazywały między sobą kolejne zbiory danych między różnymi modelami LLM, z odpowiednimi promptami i transformacjami, aby na końcu wygenerować napisy, poprawki do napisów, dubbing oraz wypalić to wszystko na nagraniu.

Według rosyjskiej cerkwi, wojna na Ukrainie i w innych krajach rozpoczęła się, ponieważ mężczyźni masturbowali się i wylewali nasienie „nie na łono własnych żon”. Takie jest stanowisko rosyjskiej cerkwi w sprawie konfliktów zbrojnych. xDDDDDDDDDDDDDDD pic.twitter.com/azRkRS6oW0

— Aryo (@AryoSomeGumul) January 15, 2025

W ramach eksperymentu napisałem sobie apkę do robienia napisów, wypalania napisów i podkładania audio i zrobiłem eksperymentalny dubbing AI.

— Aryo (@AryoSomeGumul) January 15, 2025

Brzmi trochę jak Książulo xD

Mimo żartobliwego charakteru mojego wpisu zebrał on całkiem spore grono zainteresowanych, pytających mnie w prywatnych wiadomościach o to, jak to zrobiłem. Odpowiedź, którą im przekazywałem, zawierała informacje podobne do tych poniżej.

Sklejka różnych bibliotek. Mówiąc najprościej

— Aryo (@AryoSomeGumul) January 15, 2025

Whisper ai model large v3 do rozpoznawania mowy na tekst

Potem program przekazuje wygenerowany plik .srt z napisami do modelu Phi4 z nakazem tłumaczenia z rosyjskiego na polski i tłumaczy linijka po linijce

Potem przekazuje nowy…

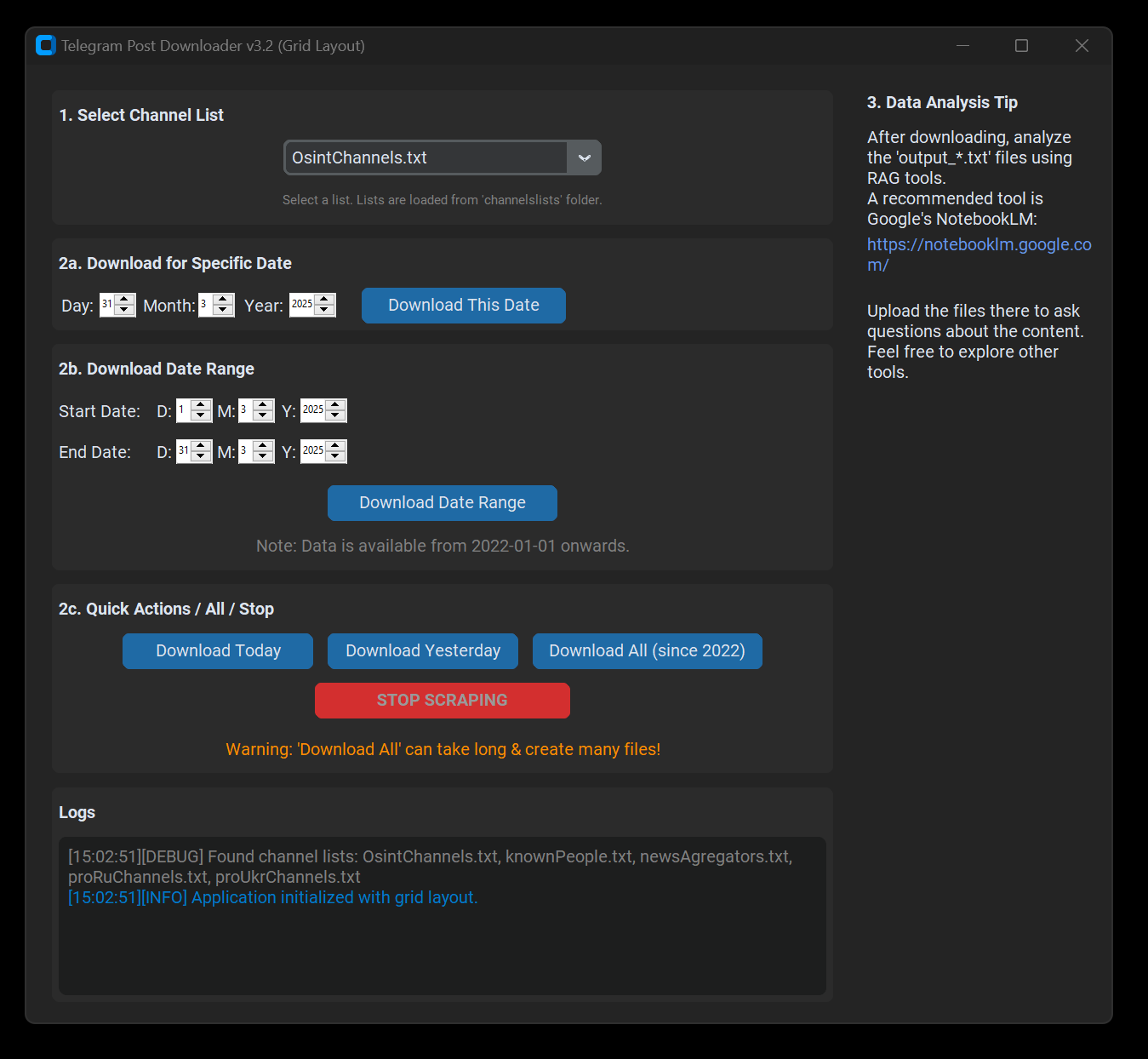

Przypominam też, że z nowych narzędzi korzystam na przykład ze scrappera danych z Telegramu, pomijającego oficjalne API. Dzięki zebranym wpisom z około 150 kanałów na Telegramie mogę użyć AI do wyszukania najszerzej komentowanych wiadomości ze wskazanego dnia. Później, jako analityk, mogę wybrać te najciekawsze i prowadzić dalsze poszukiwania informacji już w sposób tradycyjny. Takimi narzędzami mogę skrócić poszukiwania informacji z całego dnia do zaledwie kilkunastu minut.

Komentarze